英特尔那款专用AI芯片的大招已经憋三年半了。

准确来说,Nervana——英特尔砸了4.08亿美元(也有报道称3.5亿)买下的那家加州创企——他们那款专用AI芯片的大招已经憋三年半了。

2014年4月,在Nervana获得首笔60万美元的成立之初,这家公司就宣布要打造一款“深度学习专用硬件”。而在2014年8月,在获得第二笔融资(330万美元)后,其CEO Naveen Rao就表示,“用户能在大约6个月后尝试到这些深度学习专用硬件。”

三年多后,在经历了第三轮2050万美元融资并且被英特尔收购后,在今年10月17日,英特尔CEO科再奇在采访中表示,这块芯片在今年年底就会正式和用户见面。与此同时他还说,Facebook正在参与合作打造这款AI专用芯片。

然而,随着2017年转眼就要余额不足,英特尔这款Nervana专用AI芯片的还是没有正式亮相。尤其是在欧美连珠炮假日季“感恩节-圣诞节-元旦”来临的12月底,我们可以大胆地假设一句——明年见(也许是2018 CES?)

不过,虽然大招一再推迟,但是英特尔集团上下依旧对于Nervana项目十分看重。英特尔CEO科再奇不仅在不同场合内一再为Nervana站台,而且在收购Nervana后短短几个月间,前Nervana CEO就被晋升为英特尔人工智能事业部总负责人,直接向科再奇汇报——在以资历排位著称的英特尔内,晋升速度堪称火箭。

▲前Nervana CEO、英特尔人工智能事业部总负责人Naveen Rao

今天,我们就来扒一扒Nervana与这块英特尔专用AI芯片,同时也来看一看英特尔这三年多的等待和3.5亿美元的资金砸出了多大一个响来?也看看英特尔这个曾经PC时代当之无愧的霸主,如今能不能靠着Nervana在人工智能领域提刀再战?

一、比GPU更好、更快、更强大

深度学习分为训练(Training)和应用(Inference)两个阶段,Nervana芯片瞄准的是训练阶段,这一阶段需要计算机处理大量的数据,现有的CPU难以满足如此强大的计算需求,这也是英伟达靠着GPU崛起的重要原因。

目前Nervana芯片主要应用在云计算数据机房内。Nervana CEO Naveen Rao曾经表示,Nervana使用的这种新型芯片设计架构比GPU更快、功耗更低、性能更好。

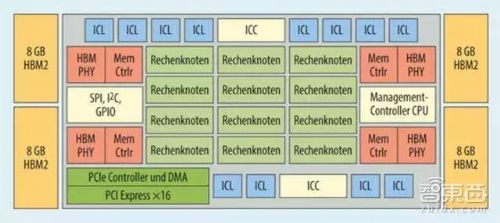

▲英特尔Nervana深度学习专用芯片设计架构

根据英特尔在2016年11月的AI Day上,我们第一次了解到了这块Nervana深度学习专用芯片的设计架。这款芯片为2.5D封装,搭载了32GB的HBM2内存,内存带宽为8Tbps。芯片中没有缓存,完全通过软件去管理片上存储。它可以支持各类神经网络算法框架的加速,比如Nervana的Neon、谷歌的TensorFlow、Facebook的Caffe等。

Nervana CEO表示,之所以这款芯片能够做到比更快CPU、比GPU更快地加速处理深度神经网络,原因有二:

1、这块芯片由“处理集群”阵列构成,处理被称作“活动点(flexpoint)”的简化数学运算,基于张量处理器的架构。相对于浮点运算,这种方法所需的数据量更少,因此带来了10倍的性能提升。

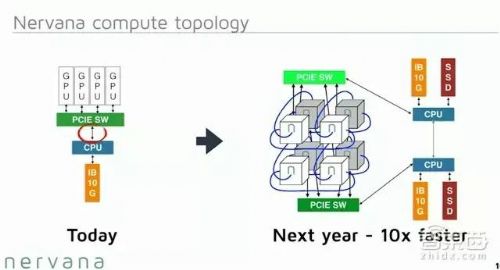

2、“互联(interconnect)”技术——这是Nervana芯片的真正亮眼之处,不过Nervana一直这一技术的细节讳莫如深——Naveen Rao将这项互连技术描述为一种模块化架构,其芯片结构可以在编程上扩展成与其它芯片的高速串行连接,帮助用户创造更大、更多元化的神经网络模型。

在GPU上,数据在芯片内部处理和芯片外部通信处理有很大的不同,必须将内存映射到I/O,在内存不同层次结构中移动数据,造成延时等复杂问题。而Nervana的互联技术能让芯片内的数据传输和芯片间的数据通信看起来一样,从而加快了处理速度。

“正如在PC时代,人们发现用GPU处理图片比CPU更快,于是转而购买独立GPU;而在人工智能时代,人们会发现用我们的芯片处理深度神经网络比GPU更好,于是转而选择我们,”Naveen Rao曾经这样说,“我们可以在硬件上打败英伟达。”

如此看来,也许英特尔这三年多的等待和3.5亿美元的资金砸得不亏?——可以说亏,也可以说不亏。

二、名不见经传的2014

让我们把时间轴调回2014年4月。

2014年4月,一家名为Nervana System(以下简称Nervana)的加州创企宣布获得60万美元融资轮融资。跟现在动辄几亿、几十亿的AI创业融资轮次来说,这金额并不算多——不过,彼时“深度学习”、“神经网络”、“人工智能”这些概念还没有现在这般火热得家喻户晓,“AI芯片”更是无从提起。

▲英特尔团队与Nervana团队合影

这家公司总部位于圣地亚哥,三位联合创始人全部来自高通:其中CEO Naveen Rao在高通神经拟态研究组(neuromorphic research group)中负责人工神经网络计算研究、CTO Amir Khosrowshahi在高通负责神经拟态传感器研究、公司的机器学习负责人Arjun Bansal则在高通负责深度学习算法研究。

正如我们所知,设计制造芯片的成本非常高昂,尤其是这样一块用于处理海量数据专用芯片。于是就在短短4个月后,Nervana宣布了他们的第二轮融资——330万美元,用于深度学习训练专用芯片的打造,彼时公司只有11个人。

在其后的采访中,Nervana CEO Naveen Rao曾经对记者表示,“用户能在大约6个月后尝试到这些深度学习专用硬件。”

其实当时市面上专注于打造深度学习专用硬件的创业公司并不止Nervana一家,其他还包括Ersatz Labs(2014年之后几乎没有消息)、Skymind(2016年9月获腾讯参投的300万美元,2017年5月又获腾讯参投的300万美元*)、Clarifai(2015年4月获1000万美元融资、2016年10月获3000万美元融资)等等。

*2017年5月这轮融资只有少数英文网站报道,中文网站没有报道

顺便一提,2014年最火的行业当属虚拟现实(VR/AR),其融资领头独角兽Magic Leap在2014年年初和年末分别获得了5000万美元A轮融资和5.42亿美元的B轮融资。这家神秘AR创企的产品同样推迟多年,听说最近他们的产品就要首次亮相了。

三、端or 云?傻傻分不清楚的2015

2015年5月,正在市场已经为Nervana的深度学习专用芯片等待了长达9个月后,Nervana忽然扔下一个重磅消息——

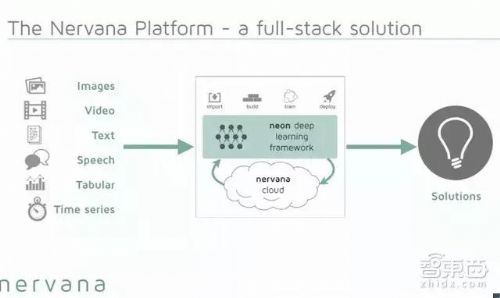

不,不是芯片推出。而是Nervana忽然宣布,公司即将推出Nervana云服务,让企业与用户能够通过网络接入Nervana云的方式获得强大的计算能力,不用受制于硬件的限制——不过当时,Nervana只是宣布了他们在打造“这朵云”,并没有公布它的面世时间。

几天后,Nervana再次宣布,开源一款深度学习软件框架Neon。这款软件框架采用Python框架、采用Maxwell GPU框架,其卷积运算速度非常快(根据GitHub上的跑分,速度已经超过了Caffe、Torch等传统框架)。

就在Neon软件框架开源后的一个月,2015年6月,Nervana宣布获得公司成立以来的第三轮融资——2050万美元,本轮融资将用于Nervana深度学习硬件和云服务平台的搭建,其中“安卓之父”Andy Rubin旗下的硬件孵化器Playground Global参投,Nervana也加入了该孵化器中。

在获得这轮融资时,联合创始人兼CTO Amir Khosrowshahi也向记者表示,Nervana曾与美国情报委员会的风险投资部门In-Q-tel签署合作协议,美国国家能源研究科学计算中心也正在使用由Nervana开发的深度学习软件Neon。

2016年2月29日,在宣布推出Nervana云服务的大半年后,这朵云终于经Nervana推出正式和大家见面。这项云服务的目的是让深度学习更快、更简单易用,专门为为缺少深度学习工具、缺少高级数据处理能力的公司打造。

不过,Nervana云暂时只能在英伟达的GPU上运行。Nervana CEO再次强调,假以时日,他们将会推出Nervana专用芯片。

此时Nervana云平台的合作伙伴已经拓宽到农业机器人初创公司蓝河科技(Blue River Technology)、 石油及天然气勘探公司Paradigm等,他们用Nervana云平台上的计算机视觉识别能力进行农作物分类、3D地形检测。

四、投身英特尔怀抱,两款芯片终于现形的2016

半年后——重头戏来了。

▲左:英特尔副总裁、数据中心事业组总经理Diane Bryant,右:Naveen Rao

2016年8月9日,英特尔忽然宣布全资收购Nervana System,收购价格在新闻稿中没有透露。当天大部分媒体在报道中提到的价格是3.5亿美元,而这一价格在第二天变成了4.08亿美元(根据Recode引援消息人士报道)。当时,Nervana全体员工只有48人。

此时距Nervana首次宣布要打造深度学习专用硬件已经过去了两年多的时间,在被英特尔收购后,这款Nervana深度学习专用芯片终于有了第一个名字——代号为“Lake Crest”,第一代产品预计将于2017年第一季度使用台积电28nm工艺进行流片测试,2017下半年开放给小部分用户使用。第二代芯片则会由英特尔自己的芯片制造生产线打造。

与此同时,英特尔还宣布将使用Nervana的技术打造一款代号为“Knights Crest”的加速器,配合英特尔的Xeon(至强)处理器使用。

此前,GPU凭借其并行计算能力一度在深度学习训练中大放异彩,不仅股价一路飙升,英伟达创始人黄仁勋(粉丝爱称“老黄”)还一再在各种场合diss摩尔定律,恐怕着实让称霸CPU多年的英特尔很是不爽。

除了一再买买买之外(收购Altera、Saffron、Movidius……)英特尔在人工智能领域一直相对低调。不过,也许收购Nervana成了砌成英特尔AI堡垒的最后一块重要砖头——就在收购Nervana的三个月后,英特尔首次公布了其人工智能的整体策略,预告了未来即将推出的一系列AI解决方案,同时在11月17日、11月30 日分别在旧金山和北京举行人工智能论坛(AI Day),表达英特尔要从芯片到软件、从架构到饮用掀起一连串AI革命的决心。

而就在这个人工智能论坛上,我们终于第一次见到这款Nervana深度学习专用芯片的面纱,也就是本文第一段内提到内容(不容易啊,都两年半了)。

转过年来,在2017年3月25日,英特尔还宣布,公司上下要整合其AI力量,构建一个统一的部门:人工智能产品事业部(ArTIficial Intelligence Products Group)AIPG,由Nervana前CEO Naveen Rao负责,直接向英特尔CEO科再奇汇报。

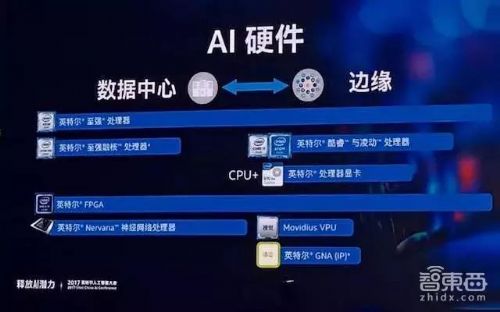

这一人工智能产品事业部将包括Xeon、Xeon Phi、Nervana和Altera等四个部分,这个新部门将整合公司的资源,包括工程、实验室、软件等等,打造英特尔Nervana平台——既有包括Nervana云计算服务、数据库、又包括Nervana专用芯片。

加入英特尔短短6个月就空降成四部门总管,这位今年仅40出头的事业部总管在一向看中年龄与资历的英特尔集团中可谓是坐了火箭了一般,足以见得英特尔内部对于Nervana这一项目的看重之处。

今年,英特尔宣布这款芯片正式命名为“英特尔Nervana神经网络处理器”(Nervana Neural Network Processors,简称NNP)在今年10月17日和《财富》杂志的采访中,英特尔CEO科再奇表示,今年年底NNP就会正式和用户见面。与此同时他还透露,Facebook正在参与合作打造这款AI专用芯片,不过他们没有正式达成书面合作协议。

与此同时英特尔还表示,公司将暂时不会单独售卖这些芯片,而是以两类形式向用户开放服务:

1、以数据中心服务器(data center appliance)的形式售卖,里面包含了几个NNP和英特尔的其他CPU。

2、通过接入英特尔的Nervana云服务,获取计算能力。

不过无论如何,2017年里我们恐怕是很难见到了。

结语:英特尔的AI芯片之旅

回到我们最开始抛出的问题,英特尔这三年多的等待和3.5亿美元(或者4.08亿)的资金砸得到底亏不亏?

——可以说亏,也可以说不亏。

在GPU崛起的时代,英伟达在人工智能训练阶段大放异彩,市值动不动一年翻一倍,一年翻三倍,老黄还常年diss摩尔定律,老牌CPU霸主英特尔固然是不爽的。

然而,异构计算的主流已经不可逆转,失去计算优势的CPU在计算机中的调度器功能逐渐加重。英特尔虽然一直在靠自我研发+“买买买”弥补其在人工智能产品线上的差距,以更好地参与到急速增长的人工智能市场中来,但是集团内没有一个拳头产品可以撑起英特尔这么大的市场。

目前,Nervana芯片依旧存在以下挑战:

1、围绕GPU,英伟达已经建立了包括CUDA、cuDNN、TensorRT等在内的一系列丰富的软件生态系统,其通用性、广泛性、开发者友好性都使得它广受欢迎。

在错过了三年的市场生态打造后,英特尔想要让厂商们舍弃自己在CUBA架构和GPU硬件上的大量投资(时间+金钱),转而投向Nervana芯片的怀抱,那这款产品必然要较之GPU有超过一个数量级的提升才足够吸引。

2、在英特尔产品一再跳票的同时,不仅有老对头英伟达在加速研发加速奔跑,各类人工智能专用AI芯片也不断崛起,就拿国内来说,寒武纪、深鉴科技、地平线等创业公司都已经在2017年下半年陆续推出(或正要推出)专用AI芯片,普遍宣布在2018年上半年进入量产,英特尔可以说是活生生把一个蓝海市场熬成了红海市场。

3、性能、速度、功耗比等方面暂时都是英特尔或是Nervana宣布的理论性能或是测试性能,在芯片进入量产之前,工程化的坑依旧有很多,最后如何达到价格、性能、稳定性等的多方平衡,仍是英特尔需要努力的方向。从英特尔决定一开始不单独售卖芯片看来,这块NNP的通用型、易用性可能还在攻克当中。

不过从另一方面讲,如果Nervana的产品真的成功量产,并且在性能、速度、功耗比等各个方面都较之GPU有着异常出色的表现,那么最起码英特尔在云计算数据中心这一人工智能领域的短板能够成功补足。再加上英伟达在边缘计算(端智能)方面由于GPU功耗较大而存在一定劣势,手握Movidius VPU低功耗视觉处理器的英特尔也许真的能够在人工智能浪潮中扳回一局。

而且,随着时间不断推移,有关NNP的信息也越来越多,越来越具体。虽然我们在2017年可能看不到这块芯片,但是在紧接着的2018 CES上,也许英特尔会给我们带来一个新惊喜。

相关专题:

相关专题: