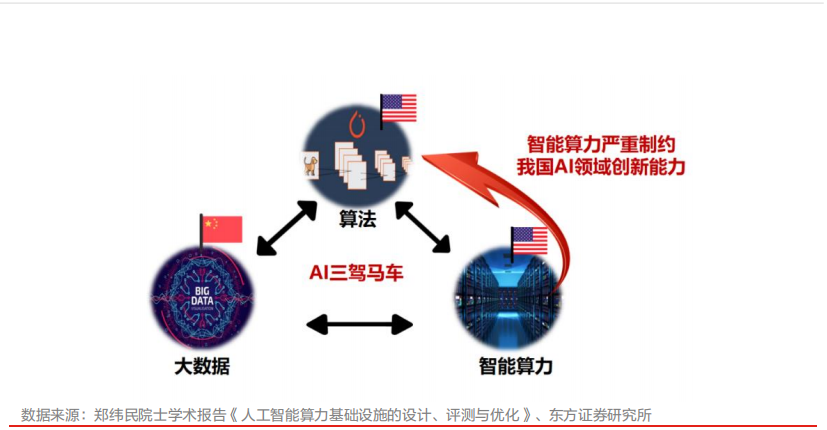

这一轮由AI技术演变带来的算力爆发,中国算力是否够用?答案是否定的,算力尤其是智能算力,已经成为制约中国人工智能发展的最关键因素。

近年来,一方面国家大力布局智能算力产业,一方面算力供给“鸿沟”却在不断扩大。这一现象的主因是AI加快了中国数字化转型,AI应用版图随之扩大,算力需求自然“水涨船高”。

另一个原因是美国禁售最强GPU进行的算力封锁。目前从国产大模型与ChatGPT的差距看,遏制手段已经生效:OpenAI之所以难以被超越,在于其拥有一个巨大的算力底座,在大模型(AI算法)的训练和推理中,首先拥有了效率优势。

算力基础决定上层应用。事实上,流向AI产业链的“每一滴水”, 最终都流向了算力。

为了避免算力产业在关键时刻被拉开差距,当下国家正在加快一体化的新型算力网络体系建设,国内云厂商也纷纷参与其中。阿里云、腾讯云、天翼云还发布了让“算力更普惠”的智算平台,硬件厂商则乘势加快了AI服务器、AI芯片、存储的国产替代进程。

算力突围战,再次打响。

01、奇点之路,算力为基

在2023财年Q1财报会上,扎克伯格称“生成式AI将触及Meta所有产品”,这已是全球第四家科技大厂做如此表态。

此前阿里曾表示“所有产品都将接入大模型”,百度强调“所有业务全面集成文心一言”;更早一些,微软“计划将ChatGPT等OpenAI的AI工具整合入全线产品”。

这说明,真正的AI时代,新的应用都会基于大模型来开发,就像十几年前的移动互联网,各种基于安卓、iOS的应用大量涌现一样。

这令人工智能的奇点,第一次以可以预见的方式展现在人们面前:AI渗透到千行百业,达到“应用奇点”,最终迎来强AI的“技术奇点”。而算力,无疑是这条“奇点之路”的路基。

这也是大模型在各种应用领域加速落地,获取更多训练参数和数据的长期意义:AI目前还在线上,但迟早会与物理世界连接。可以想象一下,如果一个基于GPT-10的ChatGPT与波士顿动力或特斯拉的人型机器人结合,会带来什么?

此逻辑并非假想。长期以来,如何令AI掌握常识并融会贯通地运用这些常识、形成推理能力,都是巨大的难题。但这次以ChatGPT为代表的大语言模型,突然就迈过这道“门槛”,成为“史上第一个真正意义上的通用人工智能”。

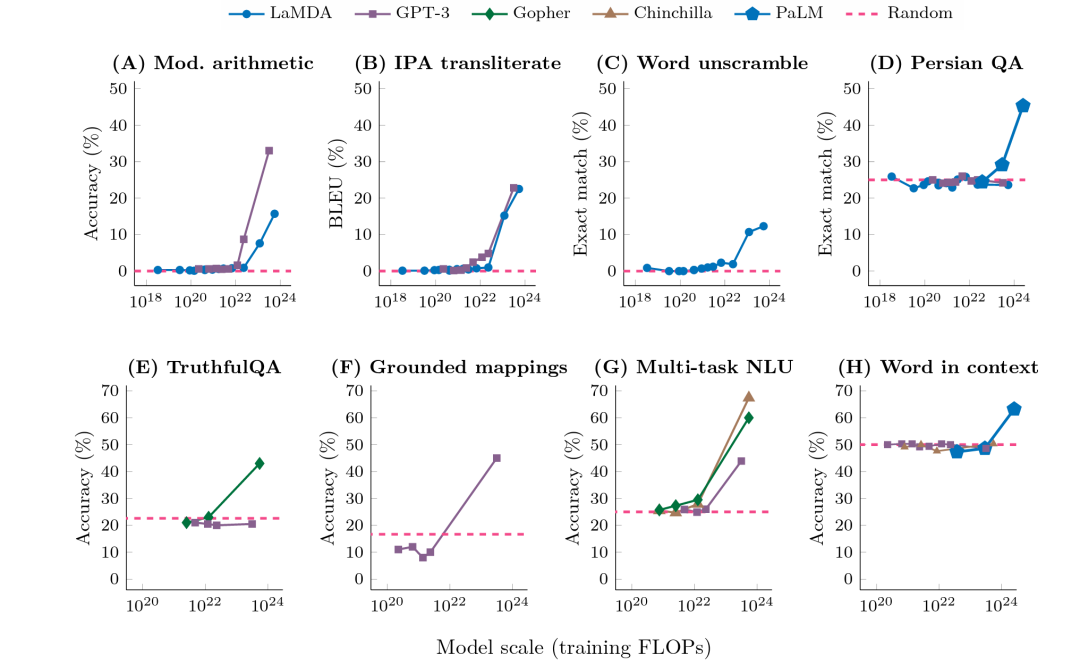

当然这背后的原因有很多,如自监督学习、Fine-tuning策略等,但一个重要的底层变化就是“涌现”(Emergent)现象。

大语言模型的涌现现象,在一定规模后迅速涌现出新能力;图片来源:谷歌、斯坦福、DeepMind:大型语言模型的涌现能力

就是说业界从未想象到的能力,例如基础社会知识、上下文学习(ICL)、推理(CoT)等等,在训练参数和数据量超过一定数值后,这些能力就突然出现了。

而人形机器人最主要的技术要点有两个,一个是机器人的本体,一个是机器人的大脑。前者的难点在于更高功率密度的驱动器,后者的难度就在于通用人工智能。

其实,早在去年8月谷歌就将大模型嵌入了机器人的大脑。今年伴随着多模态大模型的快速迭代,阿里、腾讯、微软、OpenAI等多家中美大厂,都加大了该领域的探索。

譬如在4月底,阿里云将千问大模型接入工业机器人可在钉钉远程指挥,腾讯Robotics X实验室也公布了机器人灵巧手TRX-Hand和机械臂TRX-Arm。

值得注意的是,腾讯机械手臂拥有三个手指、7个自由度,这与谷歌去年底推出的RT-1 机器人自由度一致。但相比特斯拉Optimus使用5个手指,拥有11个自由度还是有所不足。

这倒不是说腾讯的技术能力不如特斯拉。机器人本身是一项综合性的技术,不仅对硬件有着极高要求,软件算法也是机器人的核心要件,但更先进的算法需要更强的算力支撑。

英伟达A100芯片的数量不足,可能已经影响到中国企业开展更先进算法的训练和推理。

据《财经十一人》报道,目前中国企业GPU芯片持有量超过1万枚的不超过5家,拥有1万枚A100的至多只有1家。且由于美国去年8月开始算力封锁,这些存货的剩余使用寿命约为4-6年。

相比之下,特斯拉依靠领先的算力平台DOJO(使用了1.4万个英伟达的GPU,含2022年最新升级后公布的7360块A100),实际上构建了一个其他竞争对手难以企及的算力制高点。

在企业层面,另一个算力制高点是微软。其在2020年就与OpenAI合作,建成了一台号称世界前五,拥有超过28.5万个CPU核心、1万个GPU的E级超算(每秒百亿亿次数学运算)。

去年11月份,微软又宣布与英伟达合作开发新型 AI 云端超算,据说将用到“数以万计”的H100和 A100。在2023财年Q3财报会上微软也表示,将继续投资于云基础设施,特别是与AI相关的支出。

02、六年发展,差距犹存

5月4日,李彦宏在百度内部再次提起“与OpenAI差距”的问题,他称媒体报道的“大约是两个月”有点断章取义,因为后面紧接一句是:“这两个月的差距我们要用多长时间才能赶上?也许很快,也许永远也赶不上。”

李彦宏“永远也赶不上”的考量,自然包括算力上的差距,至少目前看是如此。据外媒报道,OpenAI已经使用了约2.5万个英伟达的GPU。

所以,算力也决定AI技术王权的更迭。

马斯克也不满足。上个月有消息称其抢购了一万枚A100,主攻大模型,再关联到特斯拉的智能汽车及寄予厚望的人型机器人,其对算力的需求近乎没有止境。

业内人士认为,随着AI技术的爆发和成熟,机器人发展将逐渐进入颠覆式阶段。但大模型不可能装进单体机器人大脑,它必须变成“云”大脑,通过在云、边、端分布式算法、算力和大数据,形成一个智能化的核心载体,这使机器人对算力更加依赖。

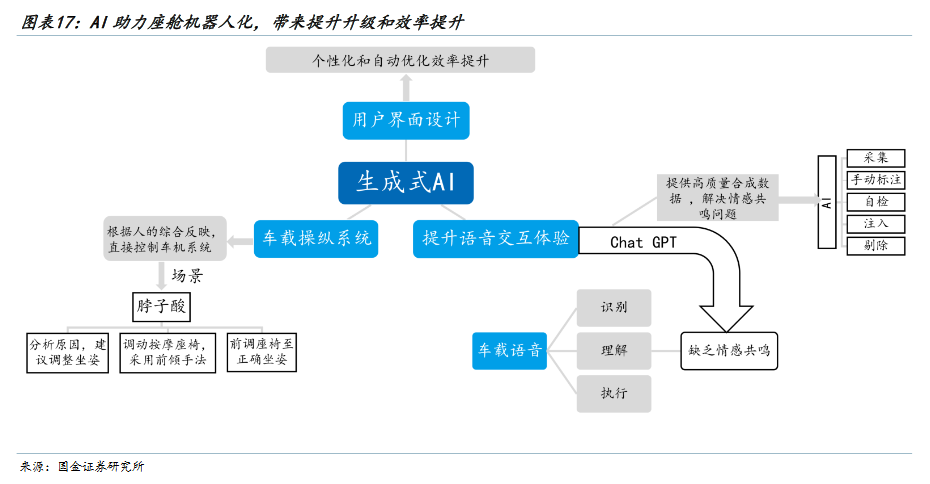

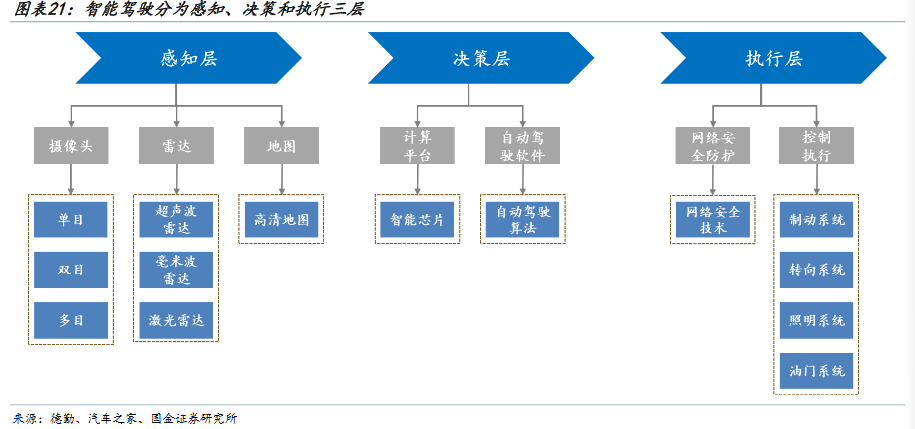

智能汽车,一样可以理解为汽车机器人,从智能座舱到自动驾驶都是“吃算力”的大户。

同时放眼宏观,这两个行业在“中国智造”的总体规划中,所占份量也自不待言。

仅人型机器人,据Stratistics Market Research Consulting预测,2035年全球市场规模将达到1520亿美元;另据SNE Research日前发布的报告,2023年全球电动汽车市场规模预计将增至1210亿美元。

也就是说,十余年后的人型机器人的市场规模,可能媲美今天的电动汽车。

为此2021年12月,工信部等多部门就印发了《“十四五”机器人产业发展规划》;今年1月,工信部等十七个部门又发布了《“机器人+”应用行动实施方案》;3月初,工信部相关负责人表示,将加快布局人形机器人、元宇宙、量子科技等前沿领域。

从中长期看,在国家政策扶持下,国产机器人乃至数字化产业各细分领域,都有望具备国际竞争力。但短期来看,这些领域所必须的智能算力,依然是掣肘因素。

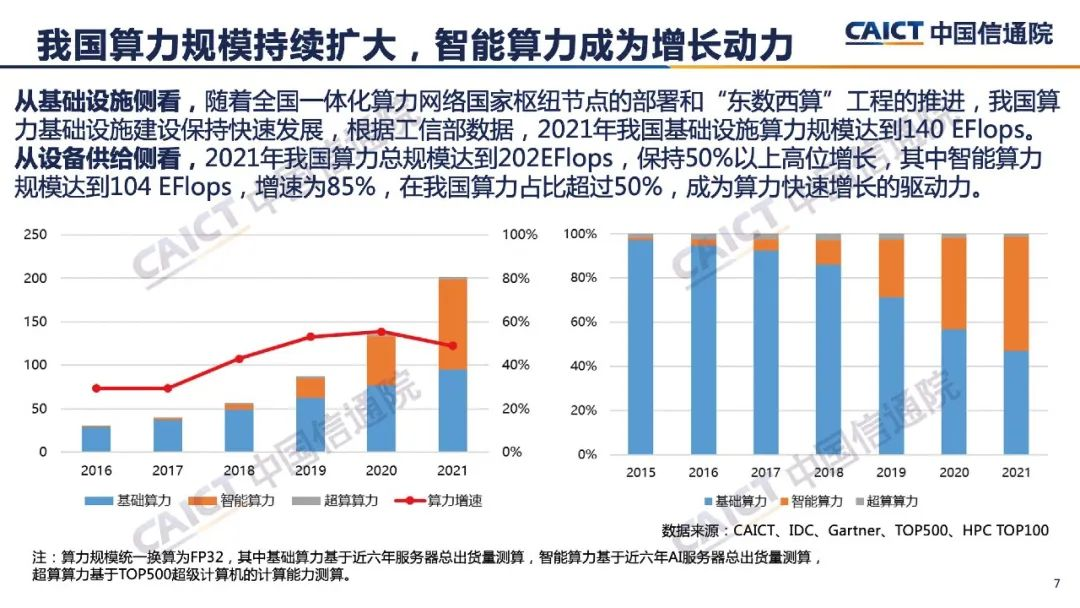

算力分为三类,即通用算力、智能算力、超算算力。一般产业数字化的场景通用算力就可满足,天体物理、航空航天等复杂运算则需要超算算力,AI应用及模型的训练和推理,对应的是智算算力。

智算,又称异构计算,相对于只用CPU的通用计算,在服务器里CPU+GPU就是异构计算,当然也可以根据应用范围采用不同的组合方式,如CPU + TPU、CPU+FPGA等。

从中国算力发展史看,最早可以追溯到中国首台超算“银河一号”诞生的1983年;2009—2011年,阿里、腾讯、华为先后入局云计算,是中国企业探索算力的起点。

2017年,国家发布了《新一代人工智能发展规划》,这一年是AI商业化应用的元年,也是中国智能算力发展的元年。

从彼时起,通用算力占比开始下降,智能算力占比开始逐渐增长。

中国信通院数据显示,2016年智能算力在中国算力中的占比仅为 3%,到2021 年占比已经超过通用算力,达到 51%。

另据IDC、清华全球产业院于2022年3月联合发布的报告,过去5年中国AI计算首次超越美国成为全球第一,AI服务器支出规模同比增长44.5%。

但必须指出的是,“智能算力占比超过通用算力”,“AI计算首次超越美国”的结论,都是基于AI服务器出货量测算,并不是实际在用的数据。

在用数据如何呢?中国信通院的公开数据表明:截至2022年底,全国在用数据中心机架总规模超过650万标准机架,算力总规模达到180EFLOPS,近五年年均增速超过了25%,位居全球第二,存力总规模超过1000 EB。当前的算力规模中,有超过20%的算力是智能算力。

《中国算力指数发展白皮书(2022)》也显示,中、美在全球算力规模中的份额分别为33%、34%,其中通用算力份额分别为26%、37%,智能算力分别为28%、45%,超级算力分别为18%、48%。

经过六年的发展,中、美总算力规模近乎持平,通用算力差距也在不断缩小,但智能算力、超级算力差距依然很大。

03、破笼解锁,关键挑战

智能算力不足,已经严重制约了我国在AI领域的创新能力,成为算力增长下的“隐伤”。

这一点也一直被业内人士所忧虑。如王恩东院士在2021年接受采访时就曾提到:“虽然目前无法具体统计AI算力缺口数据,但中国正在加速数字化转型”。

言犹在耳,这一轮大模型引发的算力需求井喷,令“隐伤”再次放大。

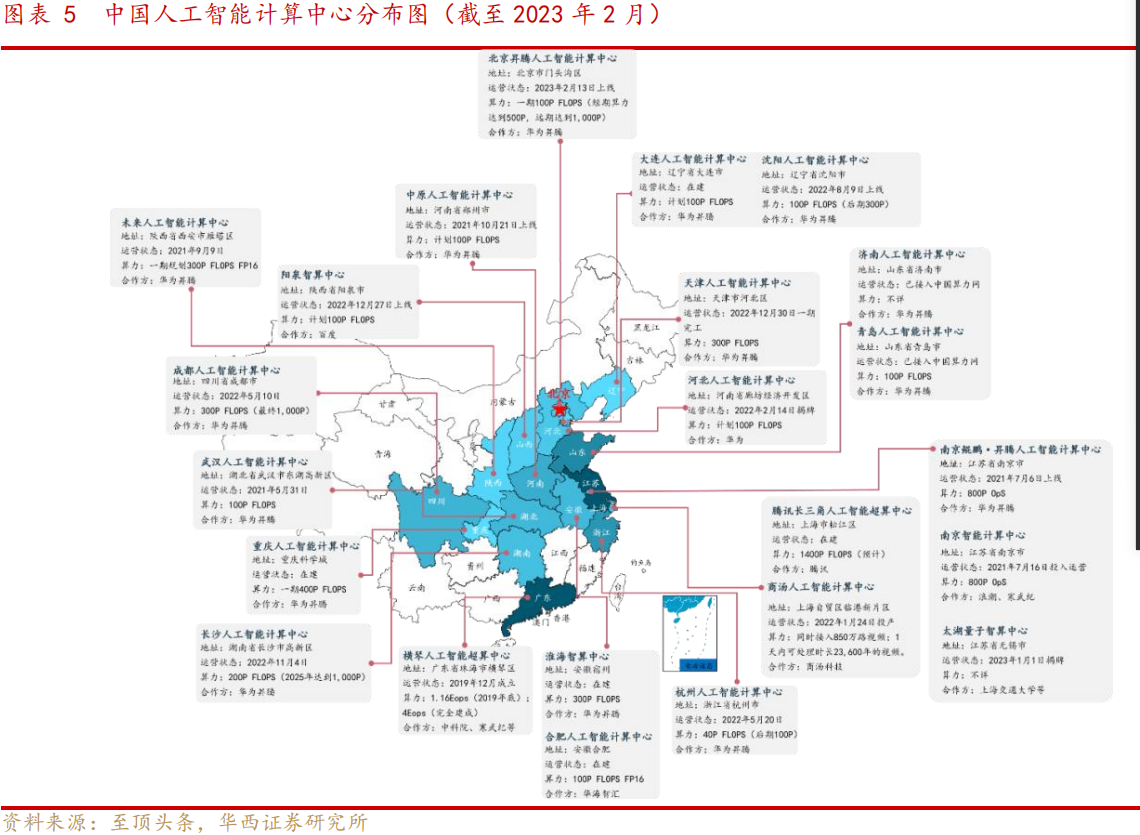

其实国家对算力发展一向重视。2020 年 4 月,国家发改委明确新基建的范围包含以智能计算中心为代表的算力基础设施,算力供给基建化自此成为趋势。

2021 年 5 月,《全国一体化大数据中心协同创新体系算力枢纽实施方案》颁布,提出布局全国算力网络枢纽 节点;2022 年 2 月 ,国家发改委等部门同意在京津冀、长三角等 8 地启动国家算力枢纽节点建设,“东数西算”工程全面启动。

据至顶智库统计,截至2023年2月,全国投入运营、在建的人工智能计算中心达23个,其中上海成为首家智算超算双中心。从合作方来看,华为、腾讯、百度等大厂都在积极参与。

智能算力规模也成倍增长。

中国信通院数据显示,2016-2021年6年间,AI服务器累计出货量超过50万台,其中2021年就达到23万台;另据TrendForce数据,2022年全球AI服务器采购量中,Google、AWS、Meta、Microsoft合计占比66.2%,字节、腾讯、阿里、百度的采购占比分别为 6%、2.3%、1.5%、1.5%。

AI芯片目前以GPU为主。IDC数据显示,国内GPU服务器在2021年占国内服务器市场规模的比例超过88.4%,英伟达的产品占比超80%。

问题来了,AI服务器通常需要4枚-8枚GPU,仅以2021年的出货量按最低配置计算,需要至少近65万枚英伟达GPU。但在美国2022年8月开始的算力封锁下,之后的订单从何而来?至少也是缩水版。

这也是中国“破笼解锁”,做强做大算力产业的关键挑战。

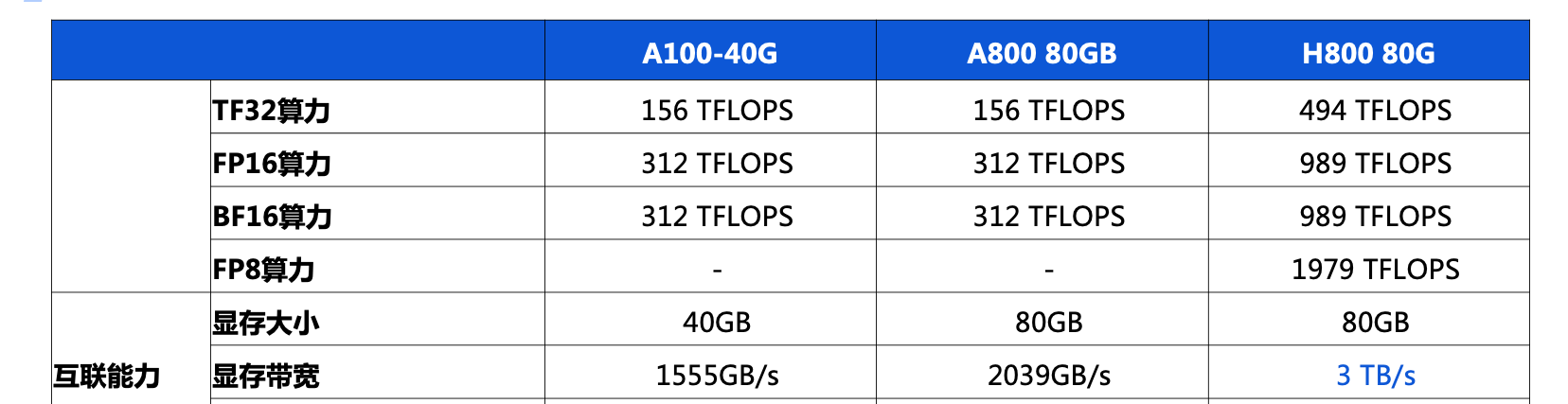

一位国内云计算从业人士表示,“在封锁背景下国产替代势在必行,但过程注定艰难”,“尤其是制程工艺的限制,美国去年限制是互联带宽超过600G,算力超过600T的产品,不能使用台积电的先进代工工艺”。

该人士解释到:“就是国内产品不能超过A100的规格,否则不能使用7nm或者5nm的生产工艺”,“目前国内有7nm产品的只有中芯国际,但从成熟度和产品产能上都和台积电有差距”。

不过这位人士认为,即使有差距,国内公司也会陆续通过中芯国际的生产工艺去生产相关芯片,并通过chiplet等先进的封装工艺将多个7nm芯片高速互联,实现算力的提升。

实际上,高性能计算芯片也不止GPU这个处理架构。如像寒武纪的ASIC和GPU是同样的应用场景,只是技术架构不一样。而算力芯片,不光只有GPU,也包含ASIC、FPGA芯片。

因此业界认为,美国封锁其实有利于国内厂商,如海光信息、寒武纪等获得更多市场份额,从而加速国产替代进程。另外,随着大模型部署成熟,对性能要求稍低的推理芯片的占比将日益提升,也有益于国产AI芯片占比提升。

同时英伟达中国市场特供产品A800、H800,虽然性能有所缩水,但在一定程度上缓解了眼下算力供给的压力,给自主替代留下了缓冲时间。

资料来源:公开信息

当下,H800正在被阿里、腾讯、百度等大厂云计算部门使用。如腾讯云发布的面向大模型训练的新一代HCC高性能计算集群,就全面搭载了 H800,互联带宽达到了目前业界最高的3.2T。

从长远来看,据国家信息中心,未来 80%的场景都将基于人工智能,算力主要由智算中心提供。所以,坚持算力国产化,才能最终破局。

为此,今年3月科技部颁布了“公共算力平台的建设指引”,要求在公共算力平台中,自主研发芯片所提供的算力标称值占比不低于 60%,国产开发框架使用率不低于 60%。

从AI服务器产业链看,浪潮、联想、新华三等国内厂商的产品已经占到全球市场30%以上的份额;支撑服务器的基础软件环节,像阿里、腾讯、百度的操作系统,也都是基于开源自主研发;数据库方面,集中式数据库国外品牌占据了市场份额90%以上,但分布式数据库国内外已经基本相当。

所以,制约中国算力发展的主要瓶颈,还是以CPUGPU为代表的芯片短板,英特尔、英伟达在国内还占据着较高的市场份额,ChatGPT大模型+CPUGPU芯片的技术垄断新联盟也初步形成。

因此,如果说“智算中心被纳入新基建”是新计算时代的算力突围,如今两年过去了,这场突围战再次打响,或从未结束。这是一场硬仗。